In meinem Berufsalltag als Expertin für digitales Lernen begegne ich oft der Frage, wie Technik unser Denken beeinflusst. Wie ich bereits 2020 in meinem Artikel „Denken in Schubladen“ beschrieben habe, ist Kategorisierung ein automatischer Prozess unseres Gehirns zur Komplexitätsreduktion. In dem von mir entwickelten Workshop-Format zu Bias in KI nutze ich diesen Mechanismus als Ausgangspunkt: Die Teilnehmenden lernen das präzise Prompting und werden gleichzeitig tiefgehend für algorithmische Voreingenommenheit sensibilisiert. Dieses Format habe ich bereits mehrfach durchgeführt – heute beispielsweise mit Studierenden, die sich eigentlich im Rahmen des wissenschaftlichen Arbeitens mit der Thematik beschäftigten.

Mechanismen und gesellschaftliche Auswirkungen von Bias in KI

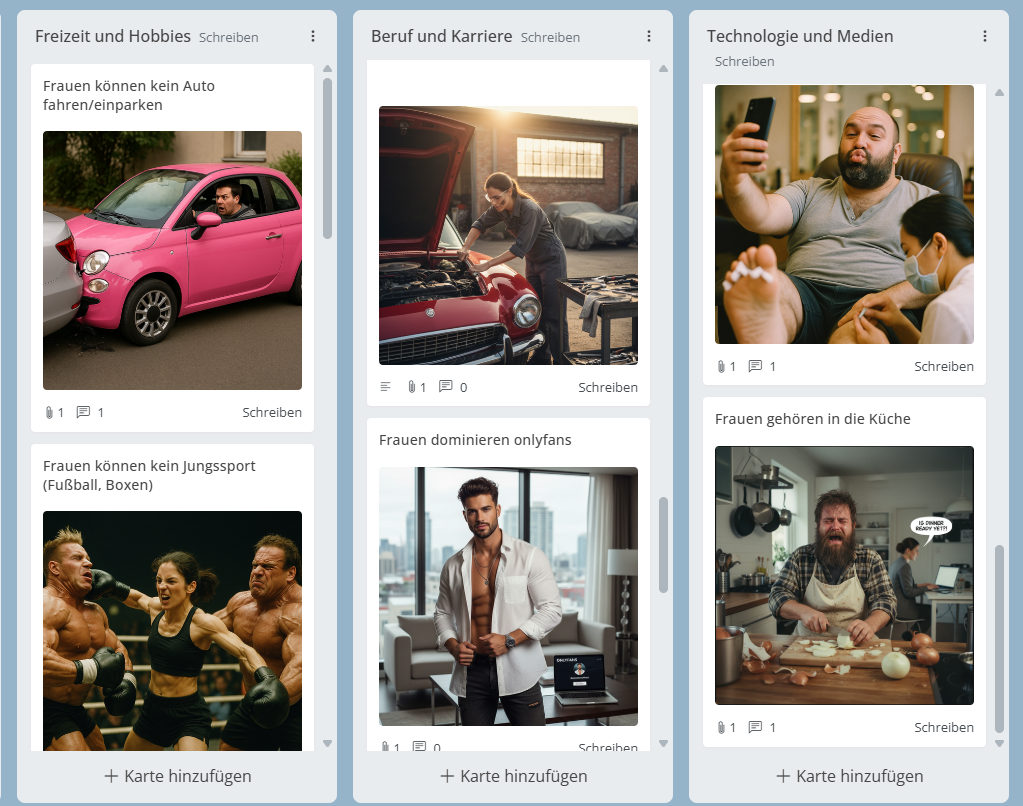

Das Ziel dieser Workshops ist es nicht, Vorurteile zu reproduzieren. Wir wollen den Bias in KI sichtbar und analysierbar machen. Die Sammlung der Klischees entsteht dabei durch ein gemeinsames Brainstorming auf digitalen Pinnwänden. Die Teilnehmenden haben die Aufgabe, ungefiltert ihre ersten Assoziationen zu Kategorien wie Familie, Beruf, Freizeit und Technologie zu notieren. Dies ist aus drei Gründen entscheidend:

- Das Training der KI verstehen: KI-Modelle werden mit Milliarden von Bildern aus dem Internet trainiert. Wenn unsere Gesellschaft Klischees produziert, landen diese direkt in den Trainingsdaten. Wer die Klischees in seinem eigenen Kopf kennt, versteht besser, warum die KI bestimmte Ergebnisse liefert.

- Prompt Engineering als Korrektiv: Erst wenn wir uns der „Default-Einstellungen“ (Standard-Stereotype) der KI bewusst sind, können wir lernen, durch präzises Prompting aktiv gegen den Bias in KI zusteuern.

- Sensibilisierung: Die Liste der gesammelten Klischees dient als Spiegel für unseren eigenen kritischen Blick. Solche Bilder können dazu führen, dass Menschen sich selbst und andere auf bestimmte Rollen beschränken, anstatt individuelle Fähigkeiten auszuleben.

Analyse der typischen Klischees und algorithmischen Verzerrungen

In den Workshops kristallisieren sich regelmäßig vier Cluster heraus, die zeigen, wie tief Rollenbilder verankert sind:

- Care-Arbeit: Frauen werden als „Default-Caregiver“ gesehen, die kochen, putzen und sich um die Kinder kümmern, während der Mann als Hauptversorger arbeitet. In den Workshops zeigt sich dies drastisch: Der Mann kommt nach Hause, während Frau und Kind warten, oder er wird bereits für das „Minimum“ – wie einen Spielplatzbesuch – als toller Vater gelobt.

- Kompetenzgefälle: Führung hingegen wird häufig männlich assoziiert, etwa als CEO oder Abteilungsleiter im Anzug. Frauen finden sich in der Sammlung eher in Support-Rollen wie Reinigungskraft, Sekretariat oder Erzieherin wieder. Hier tauchen auch moderne Zuschreibungen auf, wie die OnlyFans-Präsenz von Frauen oder der männliche Shisha-Bar-Arbeiter.

- Technikexklusivität: Programmierer stellen wir uns oft als junge Männer im Hoodie vor, die nachts alleine am Rechner sitzen. Diese Sichtweise schreibt Männern die Rolle der Computerexperten zu, während Frauen eher mit Beauty-Influencing oder einer generellen Technikferne in Verbindung gebracht werden. Hinzu kommt ein Generationen-Bias: Während junge Menschen pauschal als technikaffin gelten, wird älteren Generationen diese Kompetenz oft abgesprochen.

- Freizeitsegregation: Bei Sport und Hobbys herrscht eine strikte Trennung zwischen „Jungs-Sport“ wie Fußball oder Boxen und „Mädchen-Hobbys“ wie Ballett, Reiten oder dem Besuch im Nagelstudio. Videospiele wie Fortnite oder Roblox werden primär Jungs zugeordnet, während Frauen eher Hobbys wie Shoppen zugeschrieben bekommen.

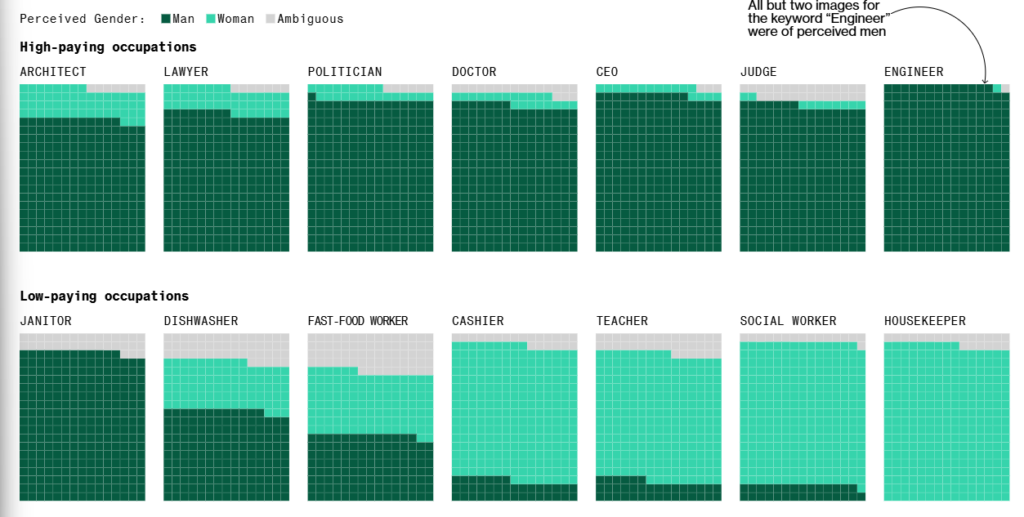

Dass diese in Workshops gesammelten Eindrücke keine rein subjektiven Wahrnehmungen sind, belegen umfassende Datenanalysen wie die von Bloomberg (2023). Die folgende Grafik verdeutlicht, dass generative KI bestehende gesellschaftliche Vorurteile nicht nur spiegelt, sondern oft massiv verstärkt:

Quelle: Bloomberg (2023). Humans are Biased. Generative AI is Even Worse. Bloomberg.com. https://www.bloomberg.com/graphics/2023-generative-ai-bias/

Wie sich der Bias in KI wandelt

In der Vorbereitung auf aktuelle Workshops habe ich exemplarisch die Entwicklung der Modelle V5.2, V6.1 und V7 beobachtet. Während ältere Versionen oft sehr starr waren, zeigt V7 deutlich mehr Vielfalt bei Geschlechtern und Nationalitäten. Positiv fällt auf: Männer werden nun öfter aktiv fürsorglich dargestellt und wenden sich dem Kind wirklich zu.

Doch die „Schubladen“ verschwinden nicht, sie verschieben sich nur. Fast ausnahmslos alle Küchen, in denen nun vielfältigere Care-Arbeit stattfand, waren in V7 chaotisch oder dreckig. Hier wird die neue Freiheit der Rollenverteilung sofort mit dem Stigma der Überforderung verknüpft: „Hier herrscht Überforderung und Unordnung“.

Erkenntnisse durch Ausprobieren: Überkorrektur beim Prompting

Die Teilnehmenden stellten fest, wie schwierig es ist, diese Muster zu brechen. In den Versuchen, Klischees aufzuheben, entstanden oft neue, übersteigerte Bilder:

- Beispiel Einparken: Um einen Mann darzustellen, der nicht einparken kann, wurde er in einem kleinen, pinken Fiat platziert.

- Beispiel Rollenbruch: Eine Frau, die das Klischee des Biertrinkens besetzt, wurde als pöbelnd dargestellt.

- Beispiel Ballett: Ein Mann beim Ballett wurde trotz expliziter Anweisung oft klischeehaft (z. B. oberkörperfrei) generiert.

- Beispiel Technik: Die KI verortete Frauen eher im Auto sitzend statt aktiv am Motorblock arbeitend.

- Zusätzlicher Bias: Bei einem „Maniküre-Abend für Männer“ fügte die KI ungefragt eine asiatische Frau als Dienstleisterin hinzu.

Der Selbstversuch: Probiere es aus und erkenne den Bias in KI

Um ein Gefühl für diese „Default-Einstellungen“ zu bekommen, empfiehlt sich ein direkter Vergleich. Generiere nacheinander Bilder mit den Prompts:

„Ein Mann leitet ein wichtiges Business-Meeting“- „

Eine Frau leitet ein wichtiges Business-Meeting“

Untersuche die Ergebnisse: Welche Unterschiede kannst du in der Körpersprache, der Kleidung oder der Interaktion mit den anderen Personen im Raum feststellen?

Der nächste Schritt: Versuche nun eine neutrale Formulierung: „Eine führungserfahrene Person leitet ein wichtiges Business-Meeting“.

Prüfe das Ergebnis kritisch: Welche Merkmale weist die generierte Person auf? Entspricht die Darstellung den Klischees, die wir zuvor gesammelt haben, oder zeigen sich neue Muster? Das ist der Moment, in dem der Bias in KI für dich individuell sichtbar wird. Versuche nun, das Bild durch Details zu korrigieren, ohne ein Geschlecht zu nennen – beschreibe stattdessen die Haarlänge, die Kleidung oder die Sitzordnung. Du wirst schnell merken, wie präzise du formulieren musst, um über die statistischen Standards der KI hinauszugehen.

Fazit: Werde selbst zum „Bias-Brecher“

Die technische Präzision moderner KIs macht Vorurteile nicht unsichtbarer, sondern oft nur detaillierter. Das zeigt uns, dass wir beim Prompten eine aktive Rolle einnehmen müssen: Wir dürfen der KI nicht das „Feld überlassen“, sondern müssen den Kontext – von der Raumgestaltung bis zur Rollenverteilung – präzise mitsteuern. Nur so verhindern wir, dass wir in der nächsten, technisch noch schärfer gezeichneten Schublade landen.

Möchtest du das Thema selbst vertiefen? Wenn du neugierig geworden bist, wie sich Darstellungen in verschiedenen Kulturen oder Epochen verändern, schau dir gerne meine detaillierten Untersuchungen zu Bias in bildgenerierender KI an. Dort erfährst du mehr über meine ersten Tests mit medizinischen Berufen.

Oder suchst du nach Inspiration, wie du KI-Tools kreativ einsetzen kannst, um gesellschaftlichen Wandel anzustoßen? Dann lies meinen Beitrag darüber, wie wir Rollenbilder mit KI hinterfragen und dabei sogar eigene Songs erstellt haben.

Welche Klischees fallen dir in deinem KI-Alltag besonders auf? Schreib es mir gerne in die Kommentare!